Gemini 2.5 Pro完全攻略【100万トークンの衝撃2025】

2024年12月、GoogleはGemini 2.0シリーズをリリースし、2025年1月にはGemini 2.5 Proで100万トークンのコンテキストウィンドウを実現しました。本記事では、圧倒的な長文処理能力を持つGemini 2.5 Proの実践的な活用方法を徹底解説します。

Gemini 2.5 Proとは

主要スペック

| 項目 | Gemini 2.5 Pro | Claude 3.5 Sonnet | GPT-4o |

|---|---|---|---|

| コンテキスト | 1,000,000 tokens | 200,000 tokens | 128,000 tokens |

| マルチモーダル | テキスト/画像/動画/音声 | テキスト/画像 | テキスト/画像 |

| 料金(入力) | $0.315/1M tokens | $3.00/1M tokens | $2.50/1M tokens |

| 料金(出力) | $1.26/1M tokens | $15.00/1M tokens | $10.00/1M tokens |

| 処理速度 | 高速 | 高速 | 超高速 |

| 日本語性能 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ |

革新的な機能

- 100万トークン処理: 書籍10冊分を一度に処理

- マルチモーダル: 1時間の動画を分析可能

- DeepThink Mode: 推論特化モード(o3に対抗)

- Native Tool Use: 関数呼び出しが超高速

100万トークンの威力

できること

1,000,000 tokens = 約750,000単語 = 約10冊の書籍

実際の用途:

✅ 年次報告書10社分を一括分析

✅ コードベース全体(中規模プロジェクト)を理解

✅ 1時間の会議動画を完全分析

✅ 100件の顧客レビューを一度に要約

✅ 医学論文50本を横断検索

実装例:大量ドキュメント分析

import google.generativeai as genai

genai.configure(api_key="YOUR_API_KEY")

# Gemini 2.5 Proモデル

model = genai.GenerativeModel('gemini-2.5-pro')

# 複数の大規模ドキュメントを読み込み

documents = []

for i in range(10):

with open(f"annual_report_{i}.txt", "r") as f:

documents.append(f.read())

# 全ドキュメントを結合

combined_text = "\n\n---\n\n".join(documents)

# 100万トークンのプロンプト

prompt = f"""

以下は10社の年次報告書です。

各社の以下の情報を抽出し、比較表を作成してください:

1. 売上成長率

2. 営業利益率

3. R&D投資額

4. 主要リスク要因

5. 今後の戦略

年次報告書:

{combined_text}

"""

response = model.generate_content(prompt)

print(response.text)

マルチモーダル処理

動画分析

import google.generativeai as genai

model = genai.GenerativeModel('gemini-2.5-pro')

# 動画ファイルをアップロード

video_file = genai.upload_file("meeting_recording.mp4")

# 動画分析

response = model.generate_content([

video_file,

"""

この1時間の会議動画を分析し、以下を抽出してください:

1. 議題のリスト

2. 各議題の発言者と要点

3. 決定事項

4. アクションアイテム(担当者・期日付き)

5. 次回会議の予定

タイムスタンプ付きで出力してください。

"""

])

print(response.text)

画像バッチ処理

# 複数画像の一括分析

images = []

for i in range(50):

img = genai.upload_file(f"product_image_{i}.jpg")

images.append(img)

response = model.generate_content([

*images,

"""

これら50枚の商品画像を分析し、以下を抽出してください:

- 商品カテゴリ

- 色

- サイズ感

- 品質評価(1-5段階)

- 価格帯の推定

CSVフォーマットで出力してください。

"""

])

# CSV形式で結果取得

print(response.text)

DeepThink Mode(推論特化)

OpenAI o3に対抗する推論モード

# DeepThink Mode有効化

model = genai.GenerativeModel(

'gemini-2.5-pro',

generation_config={

'thinking_mode': 'deep', # 推論モード

'max_output_tokens': 8192

}

)

# 複雑な数学問題

problem = """

n人が円形に座っている。

各人は隣の人と握手するか、向かい側の人と握手する。

全員が正確に1回ずつ握手するとき、

可能な握手のパターン数をnの式で表せ。

"""

response = model.generate_content(problem)

# 推論プロセスを含む詳細な回答

print(response.text)

Function Calling(関数呼び出し)

Native Tool Use

import google.generativeai as genai

# 関数定義

def get_weather(location: str) -> dict:

"""天気情報を取得"""

# 実際のAPI呼び出し

return {"location": location, "temp": 25, "condition": "晴れ"}

def search_database(query: str) -> list:

"""データベース検索"""

# 実際のDB検索

return [{"id": 1, "name": "商品A"}, {"id": 2, "name": "商品B"}]

# Geminiに関数を登録

model = genai.GenerativeModel(

'gemini-2.5-pro',

tools=[get_weather, search_database]

)

# チャット開始

chat = model.start_chat()

response = chat.send_message("""

東京の天気を確認して、

データベースから「傘」を検索してください。

""")

# Geminiが自動的に関数を呼び出し、結果を統合

print(response.text)

実践例1:コードベース全体の理解

GitHub リポジトリ分析

import os

import google.generativeai as genai

def read_codebase(root_dir):

"""コードベース全体を読み込み"""

code_files = []

for root, dirs, files in os.walk(root_dir):

# node_modules等を除外

dirs[:] = [d for d in dirs if d not in ['node_modules', '.git', 'dist']]

for file in files:

if file.endswith(('.py', '.js', '.ts', '.tsx', '.jsx')):

file_path = os.path.join(root, file)

with open(file_path, 'r') as f:

code = f.read()

code_files.append({

'path': file_path,

'content': code

})

return code_files

# コードベース読み込み

codebase = read_codebase('./my-project')

# 全ファイルを結合

combined_code = "\n\n".join([

f"# File: {file['path']}\n{file['content']}"

for file in codebase

])

# Gemini 2.5 Proで分析

model = genai.GenerativeModel('gemini-2.5-pro')

response = model.generate_content(f"""

以下のコードベース全体を分析してください:

{combined_code}

以下の情報を提供してください:

1. プロジェクトの概要

2. 主要なコンポーネント

3. アーキテクチャパターン

4. 依存関係図

5. セキュリティ上の懸念点

6. パフォーマンス改善の提案

7. バグの可能性がある箇所

""")

print(response.text)

実践例2:契約書の一括レビュー

法務文書の自動分析

# 契約書50件を一括分析

contracts = []

for i in range(50):

with open(f"contract_{i}.pdf", "rb") as f:

pdf_file = genai.upload_file(f"contract_{i}.pdf")

contracts.append(pdf_file)

model = genai.GenerativeModel('gemini-2.5-pro')

response = model.generate_content([

*contracts,

"""

これら50件の契約書を分析し、以下をレポートしてください:

1. 契約期間の一覧

2. 支払条件の比較

3. リスクの高い条項(赤字)

4. 標準的でない条項(黄色)

5. 更新・解約条件

Markdownテーブルで出力してください。

"""

])

print(response.text)

実践例3:マルチソース情報統合

ニュース記事の横断分析

import requests

from bs4 import BeautifulSoup

def fetch_news_articles(topic, num_articles=100):

"""複数ソースからニュース記事取得"""

articles = []

# Google News, Reuters, Bloomberg等から取得

sources = [

f"https://news.google.com/search?q={topic}",

f"https://www.reuters.com/search/news?query={topic}",

# ... 他のソース

]

for source in sources:

# スクレイピング処理

# ...

pass

return articles

# AI関連ニュースを100件取得

articles = fetch_news_articles("Artificial Intelligence", 100)

# 全記事を結合

combined_news = "\n\n---\n\n".join(articles)

model = genai.GenerativeModel('gemini-2.5-pro')

response = model.generate_content(f"""

以下の100件のAI関連ニュース記事を分析してください:

{combined_news}

分析項目:

1. 主要なトレンド(上位5つ)

2. 各トレンドの詳細説明

3. 企業別の動向

4. 地域別の特徴

5. 今後の予測

6. 投資家への示唆

レポート形式で出力してください。

""")

print(response.text)

Gemini vs Claude vs GPT-4o

ベンチマーク比較(2025年1月)

| ベンチマーク | Gemini 2.5 Pro | Claude 3.5 Sonnet | GPT-4o |

|---|---|---|---|

| MMLU | 90.8% | 91.8% | 90.2% |

| HumanEval | 88.2% | 92.0% | 90.2% |

| MATH | 85.7% | 78.3% | 76.6% |

| GPQA | 79.2% | 75.9% | 73.3% |

| 長文理解 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ |

| マルチモーダル | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ |

用途別推奨

| 用途 | 推奨モデル | 理由 |

|---|---|---|

| 大量ドキュメント分析 | Gemini 2.5 Pro | 100万トークン |

| コーディング | Claude 3.5 Sonnet | HumanEval最高 |

| 一般会話 | GPT-4o | 高速・低コスト |

| 動画分析 | Gemini 2.5 Pro | ネイティブ対応 |

| 長文生成 | Claude 3.5 Sonnet | 品質高い |

| 数学・推論 | o3 | 最高精度 |

料金最適化

コスト比較

100万トークン処理のコスト

| モデル | 入力コスト | 出力コスト | 合計 |

|---|---|---|---|

| Gemini 2.5 Pro | $0.315 | $1.26 | $1.575 |

| Claude 3.5 | $15.00 | $75.00 | $90.00 |

| GPT-4o | $20.00 | $80.00 | $100.00 |

結論: Gemini 2.5 Proは大量処理で圧倒的にコスパ良好

バッチ処理戦略

# バッチAPI使用でさらに50%割引

from google import genai

client = genai.Client(api_key="YOUR_API_KEY")

# バッチジョブ作成

batch_job = client.batches.create(

model='gemini-2.5-pro',

requests=[

{

"custom_id": "request-1",

"method": "POST",

"url": "/v1/chat/completions",

"body": {

"model": "gemini-2.5-pro",

"messages": [{"role": "user", "content": "..."}]

}

},

# ... 最大50,000リクエスト

]

)

# 結果取得(24時間以内)

result = client.batches.retrieve(batch_job.id)

Google AI Studio活用

ノーコードで100万トークン処理

Google AI Studio (https://aistudio.google.com)

機能:

1. ブラウザで100万トークン処理

2. プロンプトのバージョン管理

3. 複数ファイルアップロード

4. リアルタイムプレビュー

5. APIコード自動生成

無料枠:

- 月間60リクエスト(100万トークンまで)

- テスト・プロトタイピングに最適

制限事項

1. 出力トークン制限

入力: 1,000,000 tokens OK

出力: 最大8,192 tokens のみ

対策:

- 要約・抽出タスクに最適

- 長文生成にはClaude推奨

2. レスポンス時間

100万トークン処理時間: 30秒〜2分

対策:

- 非同期処理

- バッチAPI使用

3. API制限

無料版:

- 15 RPM (Requests Per Minute)

- 1,000 RPD (Requests Per Day)

- 4M TPM (Tokens Per Minute)

有料版:

- 1,000 RPM

- 無制限 RPD

- 4M TPM

まとめ:Gemini 2.5 Proを使うべき人

今すぐ使うべき人

- データアナリスト: 大量ドキュメント分析

- 法務: 契約書の一括レビュー

- 開発者: コードベース全体理解

- 研究者: 論文の横断検索

- 動画クリエイター: 長時間動画分析

他のモデルが適している人

- 短文タスク: GPT-4o(高速・低コスト)

- コーディング: Claude 3.5 Sonnet(精度高い)

- 推論タスク: o3(最高精度)

- 長文生成: Claude 3.5 Sonnet(品質高い)

Gemini 2.5 Proの100万トークンは、AI業界の常識を変えました。大量データ処理が必要なタスクでは、もはやGemini一択と言っても過言ではありません。

画像生成プロンプト集(DALL-E 3 / Midjourney用)

プロンプト1:100万トークンの可視化

Infographic visualizing 1 million tokens: stack of 10 books, arrow pointing to single AI model (Gemini 2.5 Pro logo). Comparison showing traditional models handling 1-2 books vs Gemini handling 10 books. Modern tech illustration style, blue and green gradient, impressive scale visualization.

プロンプト2:コンテキストウィンドウ比較

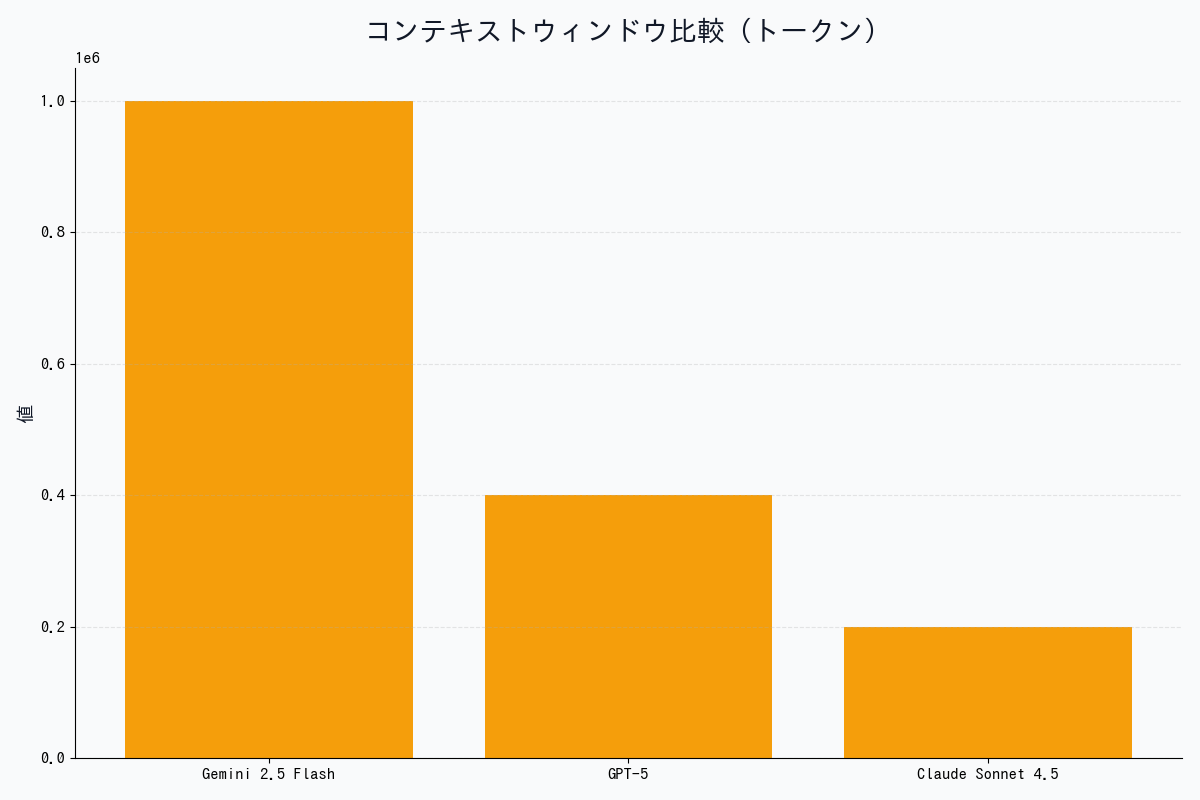

Bar chart comparing context window sizes: Gemini 2.5 Pro (1M tokens, tallest bar), Claude 3.5 Sonnet (200K), GPT-4o (128K). Logarithmic scale showing massive difference. Professional data visualization style, color-coded bars, clean grid background.

プロンプト3:マルチモーダル処理の概念図

Diagram showing Gemini 2.5 Pro processing multiple input types: text documents, images, videos, audio files → single AI model → unified output. Flowing data streams converging into Google Gemini logo. Modern AI illustration style, colorful input icons, sleek design.

プロンプト4:コスト比較インフォグラフィック

Cost comparison infographic for processing 1M tokens: Gemini $1.58 (cheapest), Claude $90, GPT-4o $100. Dollar sign icons showing dramatic price difference. Financial visualization style, green (savings) emphasis on Gemini, professional business aesthetic.

プロンプト5:ユースケース別推奨マトリックス

Decision matrix showing when to use Gemini 2.5 Pro vs other models. Axes: data volume (small to massive) and task type (simple to complex). Different use cases positioned with model logos. Clean infographic style, color zones, icons for document analysis, coding, conversation tasks.

著者について

DX・AI推進コンサルタント

大手企業グループのDX推進責任者・顧問CTO | 長年のIT・DXキャリア | AWS・GA4・生成AI活用を専門に実践ノウハウを発信中

#Gemini #Google #AI #マルチモーダル #生成AI

最終更新: 2025-11-16

この記事を書いた人

nexion-lab

DX推進責任者・顧問CTO | IT業界15年以上

大手企業グループでDX推進責任者、顧問CTOとして活動。AI・生成AI活用、クラウドインフラ最適化、データドリブン経営の領域で専門性を発揮。 実務で培った知識と経験を、ブログ記事として発信しています。